Fake news скоро станут неактуальны и неэффективны. Как и фейковые эксперты, фейковые организации и исследования (укр.)

Fake news — скоро стануть неактуальні, неефективні і нецікаві. Як і фейкові експерти, фейкові організації, фейкові дослідження. Це все будуть забавки для підлітків і політтехнологів-початківців.

Невдовзі реальний вплив на порядки денні країн, спільнот і індивідів отримає цифрова (або обчислювальна) пропаганда (computational propaganda). Поєднання обчислювальних можливостей комп’ютерів, швидкості опрацювання інформації, big data — і потреби маніпулювати сенсами.

Ми живемо в темні часи інформаційної епохи. Екстаз доступності, знання та глобальності змінився розгубленістю від величезної кількості інформаційного сміття. Інтернет та «хмарні технології» з безконечних можливостей для розвитку перетворилися на болото з псевдо-новин про лікування раку часником, содою та алое.

Банальні цитати про розвиток; реклама непотрібних товарів; теорії змови; фотошоп та діп-фейк. Ми ніби знову живемо в середньовічному селі, куди приповз скривавлений воїн, простогнав «Тікайте, бо всім кінець» і сконав. Перевірити його слова не допоможе жодна медіаосвіта, жодні тренінги медіаграмотності. І з цим сьогодні зіткнулися всі дослідники — критичне мислення неможливо сформувати за допомогою лекцій та онлайн-вікторин.

Як і в Середні віки, нові технології використовують різноманітні групи інтересів (країни, спільноти, окремі індивіди), які зацікавлені в поширенні хаосу будь-якою ціною. Для України, зокрема, існує конкретний ворог, Росія, що величезну кількість ресурсів витрачає саме на перетворення нашого інформаційного поля на смітник. Для цього використовують різноманітні методи — від оперативних (коли просто «зливають» блогерів) до мемотворчості, в яку зашивають потрібні смисли (зокрема, для роботи з молоддю).

Саме зараз ми знаходимося на певному технологічному зламі. На зміну креативу, індивідуальним рішенням, геніям пропаганди приходять бездушні машинні алгоритми, які працюють з величезною кількістю користувачів одночасно, поділяючи їх на кластери, використовуючи їхню приватну інформацію і перетворюючи їх на цільові аудиторії. Комусь — соду та часник, комусь — меч Людоти, а комусь — Трипілля як основу цивілізації.

Фейк ньюз в класичному розумінні — це розіп’ятий хлопчик: новина, вигадана і поширена в медіа за рахунок нахабства і абсурдності. І величезних грошей. Звичайно, є частина людей, що повірять цій новині і сьогодні, але це буде короткостроковий влив, і аудиторія постійно зменшується. Покоління Інтернету дуже швидко навчилося подібний абсурд вирізняти і висміювати, створювати альтернативні меми і зводити всі зусилля нанівець.

Тож цифрові пропагандисти діють принципово інакше. Вони збирають інформацію про свої цільові групи, максимально розподіляючи їх на кластери. Історія Cambridge Analitica – це не тільки про виборчі гасла; це також про те, кому сподобається картинка з Куртом Кобейном, а кому — з Алою Пугачовою.

Після цього в умовний програмний «чорний ящик» вкладають необхідні слова та смисли, і алгоритми перетворюють їх на різні формати повідомлень для різних кластерів. Так, для молоді це можуть бути тисячі згенерованих мемів з їхніми героями і фразами, які налаштовують на певне ставлення до ситуації. Для старших людей — статті про здоров’я з ненав’язливими описами бажаних станів (зневіра, депресія, агресія).

Звичайно, в це важко повірити, але просто зараз ви можете завантажити в телеграмі чатбота, який будь-яку вашу картинку перетворить на мем. Іноді досить смішний. А скоро з’явиться бот, який напише художній текст. Врешті-решт, є й протилежні інструменти — онлайн перевірка Botometer, перевірка дописів в твіттері тощо. Все автоматизоване, і все працює в мільйони разів швидше, ніж звичайні люди. Обережно, боти за роботою!

Звичайно, існує певна термінологічна дискусія. Ми по-різному використовуємо слово «бот». В наших медіа ботоферма — це технологія, за якою стоїть реальна людина, що реєструє 15-20 різних фіктивних профілів за допомогою телефонних карток і підробних сторінок паспорту. Заходить з цих профілів послідовно і пише статуси, коментарі, ставить лайки — з метою донести певну думку. Активність зводиться в певну таблицю і передається як звіт замовнику: в місяць — кілька тисяч коментарів з потрібною інформацією.

Для західних дослідників і медіа ботоферма — це «матриця». Машинний алгоритм, який перетворює роботу реальної людини на другорядну. Комп’ютер здатен зареєструвати десятки тисяч профілів, генеруючи імена, паспортні дані, використовуючи згенеровані телефонні номери. Ці профілі працюють в заданих кластерах, генеруючи мільйони повідомлень, лайків та хештегів.

Звичайно, це не буде така ж якість, як жива людина. Але кількість в даному випадку тільки плюс, адже грає злий жарт з алгоритмами соціальних мереж, які також мають певні механізми відображення коментарів, лайків і т.д. Сьогодні автоматизовані системи найбільш ефективні саме для формування трендів (тобто порядку денного), тиску на опонентів, заспамлення повідомлень або ж формування негативу.

Ще десять років тому боти були допоміжним інструментом: вони масово поширювали контент, який розробляли «тролі» та звичайні користувачі. Однак в різних країнах склалася ситуація, коли уряди або політичні сили почали все більше ресурсів витрачати саме на домінування в цифровому просторі, а для цього замало мати прихильників, потрібні потужності сучасних комп’ютерів та мільйони повідомлень.

Так, наприклад, з поверненням Володимира Путіна до президентства в 2012 році, російська державна пропаганда стала жорсткішою і агресивнішою, і боти виявилися значно ефективнішим засобом. Адже коли мета заблокувати альтернативні думки, ніж залучити їх до дискусії, кількісні атаки ботів мають перевагу. Російські пропагандисти почали використовувати методи цифрової пропаганди для впливу на баланс думок в соціальних мережах в усьому світі, наприклад, просуваючи контент або формуючи списки трендів.

Зіграли вони свою роль, наприклад, під час виборів в США в 2016 році, під час так званого Піццагейту — верхівки теорії змови про демократів, які нібито викрадають дітей і вбивають їх в піцеріях. Величезна кількість фальшивих профілів в твіттері розсилала графічні меми на цю тему, формуючи негатив до Хілларі Клінтон.

Причому географічно ці профілі знаходилися по всьому світу, на Кіпрі, в Чехії, В’єтнамі, і більшість були автоматизованими. Одним з інструментів, який вони використовували, стало просте застосування позитивних хештегів в негативних меседжах про супротивника. Таким чином, навіть прихильники Клінтон бачили в своїх стрічках суцільний негатив.

Звичайно, боти все ще не можуть комунікувати з реальними людьми на достатньому рівні. Однак ми маємо усвідомити, що це винятково питання часу, питання розвитку AI, і створення достатньої кількості сценаріїв для комунікації з 99% співрозмовників.

Методи обчислювальної пропаганди щоденно прогресують і все більше повторюють людську поведінку. Сьогодні світова тенденція до їх детекції знаходиться не у аналізі контенту, а в аналізі похідних даних. Тобто критичними для системи визначаємо не поодиноких гравців, які створюють маніпуляційний контент.

Критичною вважаємо ситуацію, коли велика кількість профілів починає діяти скоординовано, поширюючи схожу інформацію. Отже, це має бути аналіз великих даних — регіональних, кластерних, фінансових тощо. І це не може бути класичний контент-аналіз, який забезпечують 30 аналітиків в науковому інституті. Це має бути, в першу чергу, програмний інструмент, який може генералізувати великі дані, і виводити відповідні тенденції. Ці тенденції вже є базою для ухвалення рішень керівниками.

Аналіз поведінки груп, а не контенту окремих індивідів — ключова ознака протидії дезінформації сьогодні. Підґрунтя такого підходу — в тому, що поведінка живих людей є гетерогенною і менш організованою, ніж у ботів. Саме такий підхід сьогодні можна вважати пріоритетним у дослідників в багатьох країнах світу. Недостатньо медіаграмотності, замало роботи аналітиків, не вистачає ресурсів для контролю інформаційного поля.

Потрібні програмні комплекси, які зможуть об’єднати в собі можливості штучного інтелекту, розвитку мереж, роботи з великими даними. Фактично мають бути створені боти для боротьби з іншими ботами. Так, вище вже було згадано Botometer, систему детекції соціальних ботів в твітері. Вона опрацьовує більше 1200 ознак профілю і з великою вірогідністю визначає, чи знаходиться жива людина за ним.

Аналогічно учасники європейського проекту SOMA зараз працюють над системою Truly Media, яка зможе верифікувати інформацію за допомогою сотень критеріїв, значна частина яких не залежить в контенту.

У Тайвані в 2016 році було запущено бота 真的假的 (перекладається приблизно як «та невже?»), який має на меті визначати фейкові новини. Користувач надсилає йому посилання, і бот повертає його з коментарями щодо змісту. Бот все ще знаходиться в стадії розробки, однак в місцевих медіа має вже велику популярність.

Тож для майбутнього українського Центру протидії дезінформації актуальними стають виклики, які назвали дослідники Оксфордського інституту інтернету:

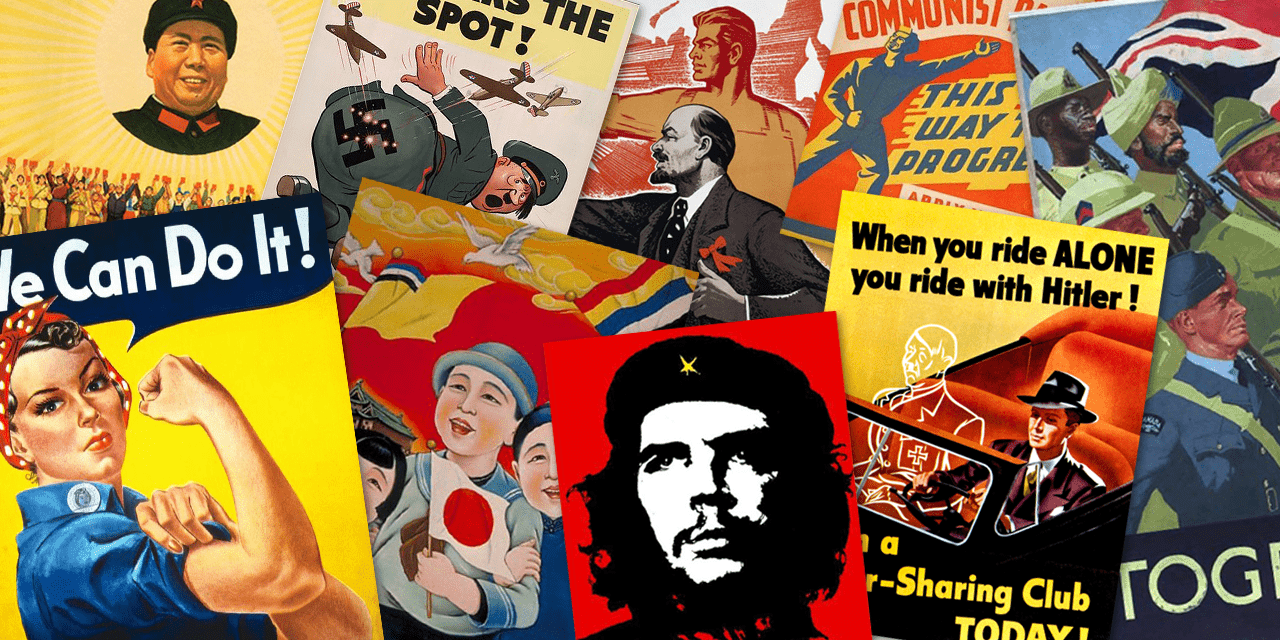

- Текст вже давно не єдиний спосіб нав’язувати пропаганду. Іноді картинки несуть сильніші повідомлення, ніж тексти. Тож стає критично аналізувати різні форми даних, і ефективно це можуть робити винятково складні програмні комплекси.

- Логічність, пояснюваність — бажана ознака системи виявлення пропаганди, адже важливо, щоб подальші дії влади (наприклад, блокування певних сайтів) мали під собою чіткі цифри та роз’яснення і не наражалися на критику. І це теж дають алгоритми, а не людські оцінки.

- Сьогодні навіть спеціально навчена людина не завжди може відрізнити синтетично створений текст. Тож для детекції дезінформації потрібні кількісні методи збору великих даних, які оперують не тільки контентними критеріями. Часто «хто, коли і в яких профілях написав» значно важливіше, ніж «що саме написав».

- Автоматизація дозволить вирішити проблему захисту даних та цензури, адже виключить вплив людей, політиків на фінальні звіти. З цією метою, звичайно, необхідно, щоб сам програмний продукт створювався за участі консорціуму незалежних організацій (в тому числі міжнародних), з утворенням Наглядової ради та на основі чітких стандартів захисту приватної інформації.

Об’єднання зусиль різних організацій, дослідницьких груп, центрів ухвалення рішень дозволить полишити суперечки в минулому і створити інструменти, які полегшать детекцію дезінформації і захистити інформаційний суверенітет України.